Llama 3は、Metaの最新の大型言語モデルです。クエリの解決、学校の宿題やプロジェクトのヘルプなど、さまざまな目的に使用できます。Windows11マシンにローカルにllama 3を展開すると、インターネットにアクセスしなくてもいつでも使用できます。この記事はあなたを示していますllama3 locallyon a windows11/10 pcのインストール方法。

Windows11PCにLlama 3をローカルにインストールする方法

Pythonを介してWindows 11/10 PCにLlama 3をインストールするには、技術的なスキルと知識が必要です。ただし、いくつかの代替方法を使用すると、Windows 11マシンにLlama 3をローカルに展開できます。これらの方法をお見せします。

Windows 11 PCにLlama 3をインストールして実行するには、コマンドプロンプトでいくつかのコマンドを実行する必要があります。ただし、これにより、コマンドラインバージョンのみを使用できます。そのWeb UIを使用する場合は、さらなる措置を講じる必要があります。これらの両方の方法をお見せします。

CMDを介してWindows 11 PCにLlama 3を展開します

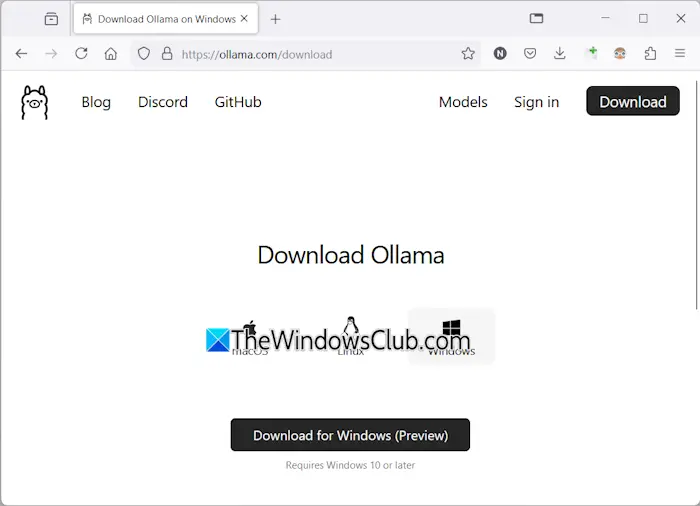

Windows 11 PCにLlama 3を展開するには、WindowsマシンにOllamaをインストールする必要があります。同じことの手順は次のとおりです。

- 訪問オラマの公式ウェブサイト。

- をクリックしますダウンロードボタンと[選択]を選択しますWindows。

- 次に、をクリックしますWindows用のダウンロードPCにEXEファイルを保存するボタン。

- exeファイルを実行して、マシンにオラマをインストールします。

オラマがデバイスにインストールされたら、コンピューターを再起動します。バックグラウンドで実行されるはずです。システムトレイで見ることができます。次に、Ollama Webサイトのモデルオプションをクリックします。その異なるモデルが表示されます。

Llama 3.1は、次の3つのパラメーターで利用できます。

- 8b

- 70b

- 405b

最後のものは最大のパラメーターであり、明らかにローエンドPCで実行することはできません。 Llama 3.2には、次の2つのパラメーターがあります。

- 1b

- 3b

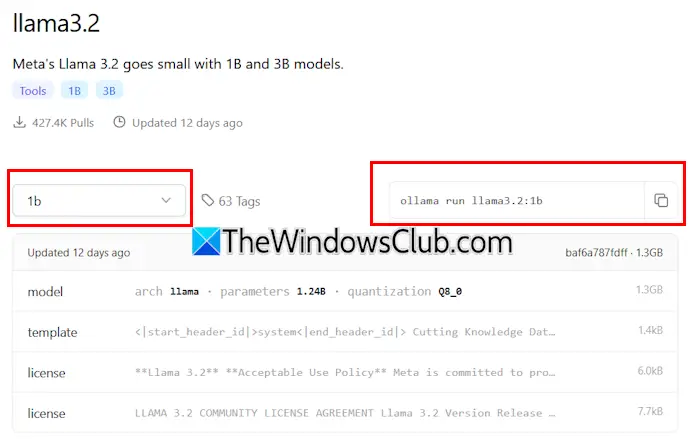

PCにインストールするLlamaバージョンをクリックします。たとえば、Llama 3.2をインストールする場合は、Llama 3.2をクリックします。ドロップダウンでは、インストールするパラメーターを選択できます。その後、その隣のコマンドをコピーして、コマンドプロンプトに貼り付けます。

あなたの便宜のために、私はLlama 3.2モデルの両方のコマンドを書きました。 llama 3.2 3bモデルをインストールするには、次のコマンドを実行します。

ollama run llama3.2:3b

LLAMA 3.2 1Bモデルをインストールするには、次のコマンドを使用します。

ollama run llama3.2:1b

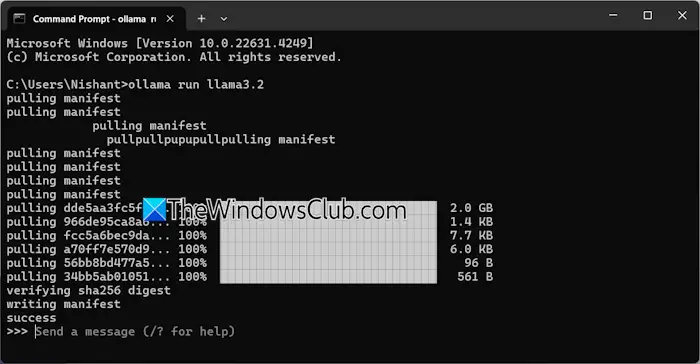

コマンドプロンプトを開き、上記のコマンドを入力して(要件に基づいて)、ヒットします入力。必要なファイルをダウンロードするには時間がかかります。ダウンロード時間は、インターネット接続速度にも依存します。完了後、成功コマンドプロンプトのメッセージ。

次に、メッセージを入力してLlama 3.2モデルを使用します。 Llama 3.1モデルをインストールする場合は、Ollama Webサイトで利用可能なコマンドを使用してください。

次回コマンドプロンプトを起動するときは、同じコマンドを使用して、PCでllama 3.1または3.2を実行します。

Llama 3からCMDをインストールするには、1つの欠点があります。チャットの履歴を保存しません。ただし、ローカルホストに展開すると、チャット履歴が保存され、より良いユーザーインターフェイスが得られます。次の方法は、それを行う方法を示しています。

Windows 11にLlama 3 Web UIを展開します

WebブラウザでLlama 3を使用すると、より優れたユーザーインターフェイスが提供され、CMDウィンドウで使用するのと比較してチャット履歴も保存します。 WebブラウザにLlama 3を展開する方法を紹介します。

WebブラウザでLlama 3を使用するには、Llama 3を介してOllamaとDockerをシステムにインストールする必要があります。 Llama 3をまだインストールしていない場合は、Ollama(上記のように)を使用してインストールしてください。次に、DockerからDockerをダウンロードしてインストールします公式ウェブサイト。

Dockerをインストールした後、起動してサインアップしてアカウントを作成します。 Dockerはサインアップするまで実行されません。サインアップしたら、Dockerアプリでアカウントにサインインします。システムトレイへのDockerを最小限に抑えます。 DockerとOllamaアプリはバックグラウンドで実行されているはずです。それ以外の場合は、Webブラウザでllama 3を使用することはできません。

次に、コマンドプロンプトを開き、次のコマンドをコピーし、コマンドプロンプトに貼り付けます。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

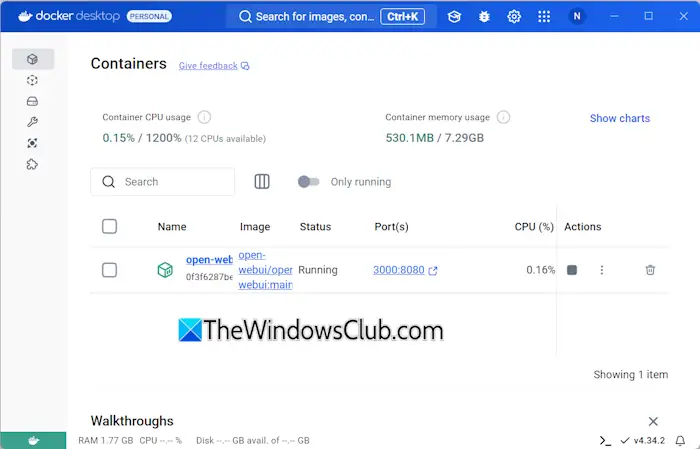

上記のコマンドは、必要なリソースをダウンロードするのに時間がかかります。したがって、ある程度の忍耐があります。コマンドの完了後、Dockerを開いて選択しますコンテナ左側からのセクション。ポート3000:8080でコンテナが自動的に作成されることがわかります。

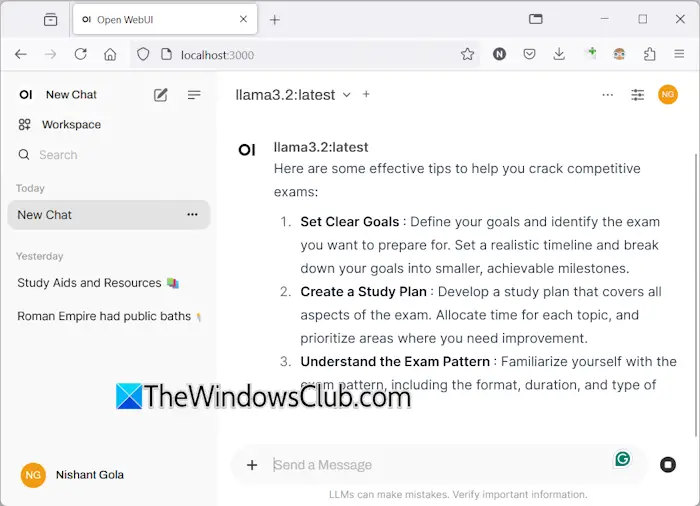

ポート3000:8080をクリックします。これにより、デフォルトのWebブラウザに新しいタブが開きます。次に、サインアップしてサインインして、WebブラウザーでLlama 3を使用します。アドレスバーが表示されている場合は、表示されますLocalHost:3000そこには、Llama 3がコンピューターでローカルにホストされていることを意味します。インターネット接続なしで使用できます。

ドロップダウンからllamaチャットモデルを選択します。 Llama 3のチャットモデルを追加する場合は、必要なコマンドを使用してOllama経由でインストールする必要があります。その後、モデルはWebブラウザで自動的に利用可能になります。

チャットの履歴はすべて保存され、左側にアクセスできます。終了する場合は、Webブラウザでセッションをログアウトします。その後、Dockerアプリを開き、停止Dockerを停止するボタン。これで、Dockerを閉じることができます。

次回WebブラウザでLlama 3を使用する場合は、OllamaとDockerを起動し、数分待ってから、DockerコンテナのポートをクリックしてWebブラウザーのLocalHostサーバーを開きます。次に、アカウントにサインインして、Llama 3の使用を開始します。

これが役立つことを願っています。

Llama 3はWindowsで実行できますか?

コンピューターのハードウェア構成に応じて、システムでllama 3を実行できます。その1Bモデルは最も軽いです。コマンドプロンプトを介してシステムにインストールして実行できます。

Llama 3にはどれくらいのRAMが必要ですか?

Llama 3の最も軽いモデルはLlama 3.2 1bです。システムには、Llama 3.2 1Bモデルを実行するために16 GBのRAMが必要です。これに加えて、システムには頑丈なGPUも必要です。 Llama 3のより高いモデルには、より多くのシステムリソースが必要です。

次を読んでください:レオナルドフェニックスAIの使用方法。