LLMの代金を支払いたくない場合、またはデータを安全に保ちたい場合は、Localgptを設定する必要があります。これにより、AIがどのようにデータを動作させ、処理するかを完全に制御できます。また、外部サーバーに送信される代わりに、すべてのデータがローカルシステムにとどまるため、プライバシーが保証されます。

Windows PCにローカルGPTを設定します

Localgptは、インスピレーションを受けたオープンソースツールですprivategpt、プライベートで使用するためにユーザーデバイスでローカルに大規模な言語モデル(LLM)を実行するように設計されています。 CPU実行のみに依存するPrivategptとは異なり、LocalGPTはGPUを介したハードウェアアクセラレーションをサポートし、パフォーマンスを向上させ、遅延を削減します。 GPT-4ALLモデルとラマエムベッドディングの代わりに、かなり膨大なものであるLocalGPTは、Vicuna-7B LLMとInstructorembeddingsを使用しています。 BlenderBotやWizardLM-7Bなどのモデルで動作し、特定のニーズに基づいてモデルを交換できるようにします。パイプライン全体がローカルで動作し、外部APIリライアンスなしで高度なNLP機能を提供しながらデータプライバシーを確保し、ローカルで動作するAIモードの完璧な候補となります。

このガイドでは、WindowsにローカルGPTをセットアップします。以下の手順に従うことができます。

- Minicondaをダウンロードしてインストールします

- LocalGPTリポジトリをインストールします

- 依存関係をインストールします

- localgptを実行します

それらについて詳しく説明しましょう。

1] Minicondaをダウンロードしてインストールします

![]()

Minicondaは、Python環境をすばやくセットアップするように設計されたConda Package Managerの軽量分布です。必要に応じて特定のパッケージを追加して、ユーザーがインストールをカスタマイズできるようにするため、必需品のみを提供します。それをダウンロードするには、anaconda.comに移動し、下にスクロールして、ミニコンダインストーラー、このガイドはWindows用であるため、Windows用にダウンロードしてください。

![]()

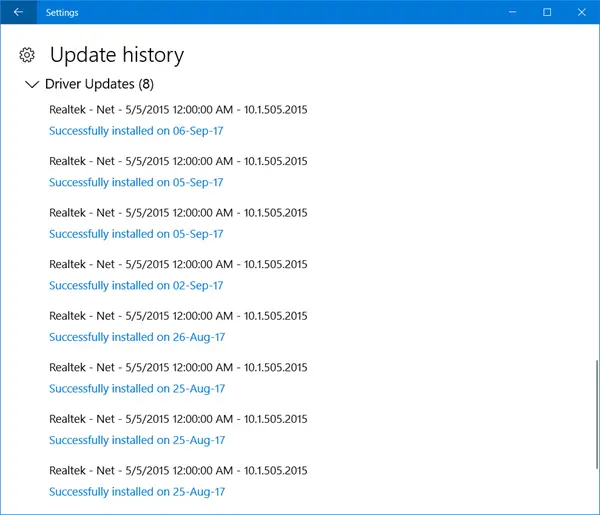

次に、インストーラーを実行し、画面上の手順に従ってインストールプロセスを完了します。高度なインストールオプション、すべてのボックスにチェックを入れ、最後にインストールを完了します。

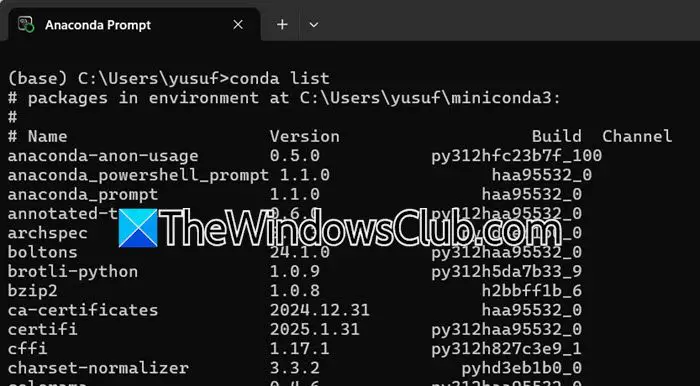

インストールされているかどうかを確認するには、検索してください「アナコンダプロンプト」[スタート]メニューでCLIを開きます。これで、実行できますコンドラリストインストールされていることを確認するために。

2] LocalGPTリポジトリをインストールします

これで、localgptリポジトリをインストールする必要があります。プロンプトエンジニアによってGithubでホストされています。そこから入手できます。そうするために、にナビゲートしますgithub.com。ページを通過して、Localgptの詳細を確認してインストールするには、クリックする必要があります。コード> zipをダウンロードします。zipファイルがダウンロードされたら、に移動しますダウンロードフォルダー、zipファイルを右クリックし、抽出を選択し、ファイルを抽出する場所を設定し、プロセスを完了します。抽出されたフォルダーを開きます。localgpt-main。簡単にするために、デスクトップのフォルダーを貼り付けて名前を付けています「LGPT」。

3]依存関係をインストールします

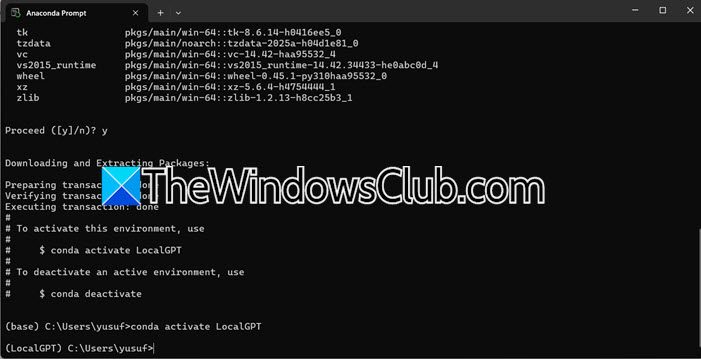

次に、すべての依存関係をインストールする仮想環境を作成する必要があります。そうするために、を開きます「アナコンダプロンプト」[スタート]メニューから、次のコマンドを実行します。

conda create -n environment_name python=3.10

conda activate environment_name

注:変数「環境_name」を選択した名前に置き換えます。

パッケージをダウンロードするように依頼した場合は、同意を与えて続行してください。

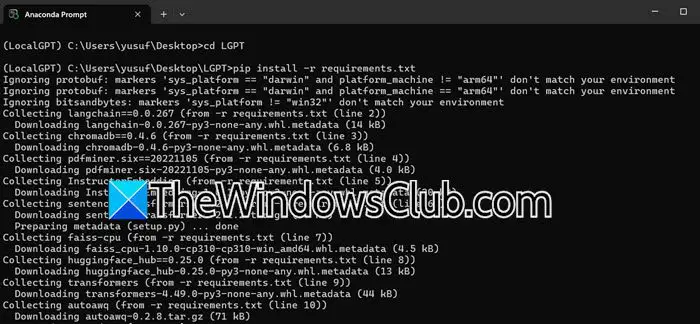

次に、以前に抽出したものをダウンロードしたパッケージをインストールする必要があります。そのためには、最初に次のコマンドを使用してディレクトリに移動する必要があります。

cd Desktop

cd LGPT

すべてのコンポーネントを1つずつインストールする代わりに、次のコマンドを使用してそれらすべてを一度にインストールできます。

pip install -r requirements.txt

2つのエラーが発生する可能性があります。

- トーチmodulenotfounderrorのインポート:走る

PIPインストールTorch TorchVision Torchaudioそして、前述のコマンドを実行します。

- Microsoft C ++が必要です:前述のURLをクリックし、クリックしてVisual Studioをダウンロードしてくださいビルドツールをダウンロードし、Visual Studioがオープンしたら、持っていないツールを実行してダウンロードする必要があります。

問題を解決した後、インストーラーコマンドを再度実行し、インストールしたら、次のステップに進みます。

4] localgptを実行します

まず、ソースドキュメントからデータをインポートし、ドキュメントを処理し、埋め込みをベクターデータベース(Chroma DB)に保存することを意味する、Python摂取を実行する必要があります。そのためには、次のコマンドを実行する必要があります。

python ingest.py

タスクマネージャーを使用して、CPUの使用に注目することをお勧めします。

今、alocalgptディレクトリ内の定数ファイルをcassします。ラインにコメントを追加してLlama 3モデルを無効にし、コメントを削除してLlama 2モデル(7bパラメーター)をアクティブにします。

完了したら、次のコマンドを使用してLocalGPTを実行する必要があります。

python run_local_gpt.py

それを示すエラーが発生した場合ラマ行方不明です、実行しますピップインストールllama-cpp-python。

うまくいけば、このガイドの助けを借りて、コンピューターでローカルでローカルで実行できるようになることを願っています。

読む: 研究に困惑AIを使用する方法

Windowsにprivategptをインストールする方法は?

WindowsにPrivategptをインストールするには、最初にPythonとCondaのようなパッケージマネージャーをインストールします。次に、privatepttリポジトリをクローンして、仮想環境をセットアップします。その後、詩またはピップを使用して依存関係をインストールする必要があります。互換性のある言語モデルをダウンロードします。最後に、環境変数を構成し、ドキュメントを摂取し、アプリケーションを実行してデータの照会をローカルで開始する必要があります。

読む:Windows 11でDeepseekをローカルに実行する方法

WindowsでWSLをセットアップする方法は?

にWindowsにWSLを設定します、管理者としてPowerShellを開き、実行しますWSL –Install。これにより、WSLが有効になり、Linuxカーネルをインストールし、WSL 2をデフォルトとして設定します。コンピューターを再起動し、インストールするLinuxディストリビューションを選択します。配布を起動し、ユーザー名とパスワードを設定すると、WindowsでLinuxを使用する準備が整います。