LMスタジオあなたを可能にするツールですローカルの大手言語モデル(LLMS)を実行するあなたのコンピュータで。このユーティリティの最良の点の1つは、最大限のプライバシーを確保するためにモデルをローカルで実行できることです。このガイドでは、私たちは行きますオフラインPCで複数のAIを使用するようにLMスタジオを構成し、したがって、興味がある場合は、読み続けてください。

オフラインPCで複数のAIを使用するようにLMスタジオを構成する

LMスタジオインターネットを必要とせずに、コンピューターに大きな言語モデルをダウンロードして実行できます。すべてをローカルで処理することにより、データをプライベートに保つのに役立ちます。これにより、コンテンツの作成やデータ分析などのタスクに複数のAIモデルを使用できます。オフラインPCで複数のAIを使用するようにLMスタジオを構成する場合は、以下の手順に従ってください。

- LMスタジオをインストールします

- 複数のモデルをインストールします

- モデルの使用を開始します

それらについて詳しく説明しましょう。

1] LM Studioをインストールします

まず、公式ウェブサイトからLM Studioツールを入手する必要があります。だから、そのために行く必要がありますlmstudio.ai。 Windowsを使用しているため、選択しますWindows用のLMスタジオをダウンロードし、ただし、プラットフォームに応じて、LM Studioバージョンをダウンロードする必要があります。完了すると、これにより、尊敬されるexeファイルのダウンロードがトリガーされます。

LM Studioインストールメディアをダウンロードした後、それをダブルクリックしてから、アプリケーションをインストールするユーザーを選択します。すべてのユーザーにインストールする場合は、UACプロンプトが取得されるため、管理者アクセスが必要です。アクセスできるので、それを行い、フォルダーを選択し、最終的にアプリケーションを起動しました。

2]複数のモデルをインストールします

LM Studioを立ち上げたら、最初のLLMモデルをダウンロードするように求められます。最初のLLMを取得してください、そして、提案されたモデルをダウンロードします。場合に備えて、独自のモデルを選択するには、クリックしてください搭乗をスキップします。

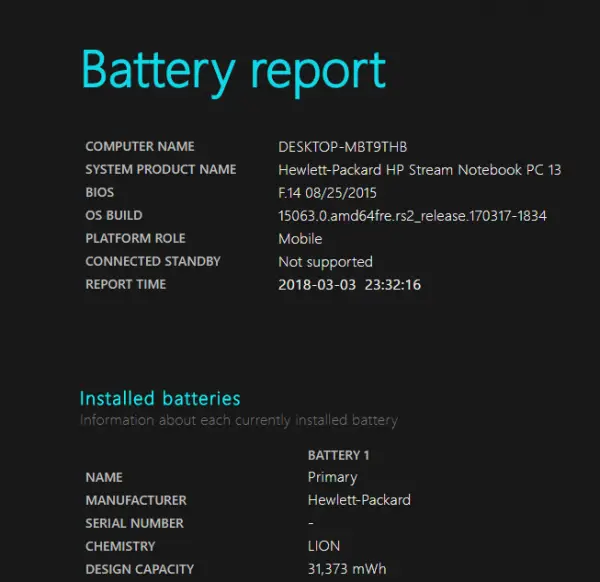

LLMモデルをダウンロードするには、をクリックする必要があります発見(拡大ガラス)アイコン。次に、ダウンロードするモデルを検索します。 LM Studioの最良のことの1つは、システムの詳細をチェックし、モデルがマシンに大きすぎるかどうかを確認するという事実です。たとえば、Deepseek Coder V2 Lite私のデバイスには大きすぎますが、3.2 1bに電話してくださいスムーズに実行されます。

どのモデルがマシンで動作するかがわかったら、ダウンロードアイコンとモデルをダウンロードさせます。ネットワークの帯域幅によっては、時間がかかる場合があります。

これにより、ランタイムとともにLLMモデルがダウンロードされます。ただし、私の場合、別のモデルにアップグレードしたい場合は、強力なGPUを持っていないのでCPU llama.cppをインストールしたいと思っていました。私はに行きましたランタイムタブ、クリックしましたアップデートランタイムモデルの横にあるボタン。

ダウンロードするため別のモデル、に行く必要があります発見するもう一度ボタン、ダウンロードするモデルを探してください。次に、をクリックしますダウンロードそれに関連付けられたボタン。モデルをダウンロードするので、数分待ちます。ダウンロードされたら、に移動できますランタイム利用可能な場合は更新をダウンロードしてください、そして必要に応じて、そしてあなたがしなければならないのはクリックすることだけですモデルをロードします。これにより、そのモデルのサーバーがコンピューター上でローカルに起動します。

注:モデルを起動せずに発見プロンプトを閉じた場合は、画面の左下隅からダウンロードアイコンに移動し、モデルに関連付けられているロードモデルを選択します。

3]モデルの使用を開始します

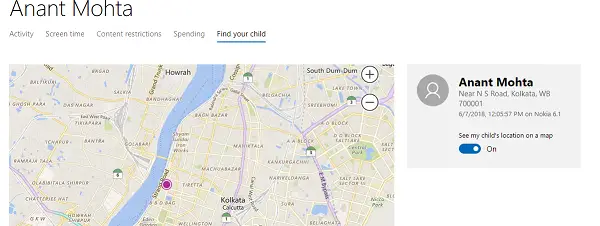

モデルをダウンロードした後、必要なのはチャットアイコンに移動することだけです。次に、ウィンドウの上部を見れば、すべてのモデルが表示されます。モデル選択したいこと。

モデルを使用する前に、モデルの設定を変更することもできます。そのためには、モデルの横にあるサイド矢印をクリックしてから、次のような設定を変更しますGPUオフロード、CPUスレッドプールサイズ、コンテキストの長さ、その他のオプション。完了したら、クリックするだけですロードモデル。

モデルがロードされたら、チャットボットに移動して、AIモデルとのチャットを開始します。ウィンドウの右下隅にあるRAMとCPUカウントに注意してください。

うまくいけば、このガイドの助けを借りて、LM Studioで複数のLLMモデルを実行できるようになることを願っています。ただし、他にもありますLLMをローカルに実行するためのツール、あなたもそれらをチェックアウトする必要があります。

読む:WindowsのMSTY LLMは安全ですか?インストールする方法は?

LMスタジオはオフラインで動作しますか?

はい、LMスタジオオフラインで動作します。必要なモデルとランタイムをダウンロードしたら、インターネット接続なしで完全に使用できます。すべての処理はマシン上でローカルで行われ、データがプライベートであることを確認します。

読む:LLMS Claude、Copilot、ChatGpt、Geminiを使用してAIエージェントを作成します

LM StudioにはどのくらいのRAMが必要ですか?

LM Studioのすべてのモデルには、RAM要件が異なります。ただし、問題なくモデルを実行したい場合は、少なくとも16 GBのRAMを使用することをお勧めします。さらに、GPUを追加する能力がある場合は、それを行います。